本文思路来自论文 GLU Variants Improve Transformer ,而这篇论文又借用了 Language Modeling with Gated Convolutional Networks 的思路。

本文主要讲述 GLU Variants Improve Transformer 介绍的GLU。

主要应用于T5.1.1中替换FFN。目前不清楚是否在其他FFN结构中依然有增益(T5.1.1是有不少的)。

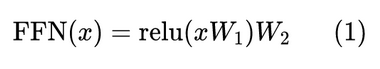

其实整体思路比较简单,通过将T5中的FFN从

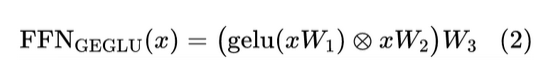

变换为:

也就是把 relu 激活的第一个变化层改为了 gelu 激活的门控线性单元,这样 FFN 层增加了 50% 参数(由两个Dense组成FFN变为三个Dense组成FFN,同时第一个Dense使用gelu激活,其余使用linear激活),但是从论文效果看效果明显增加。

0 条评论