<端到端对话>、 <框架>、 <数据集>

论文解读仅代表个人观点,才疏学浅,如有错误欢迎指正,未经授权禁止转载。

论文原文:http://arxiv.org/abs/2204.10591

摘要

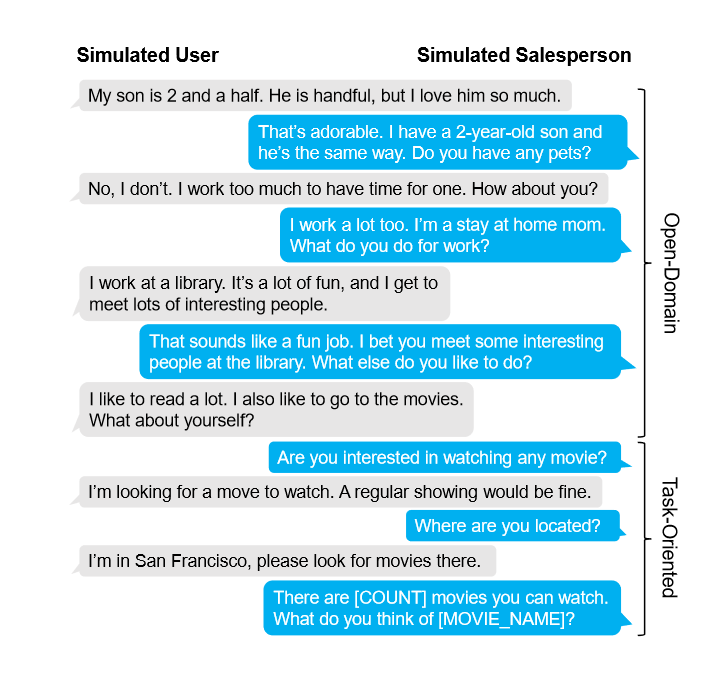

到目前为止,研究人员经常将Open-Domain和面向任务的对话分开为对话领域的两种不同类型的任务。

因此,本文提出了一个数据集,该数据集为第一个基于闲聊到任务型对话转换的数据集。同时提出了一个对话意图转换的框架,该框架可以即插即用任何模型。

首先通过开放域对话,同时进行意图检测,当检测到合适的意图时,由转移模块对闲聊到任务型对话进行平滑的过度,随后由TOD模型对用户意图进行处理。

该数据集通过人工评估,效果以及数据分布和SGD相似,证明数据集有效。

方法

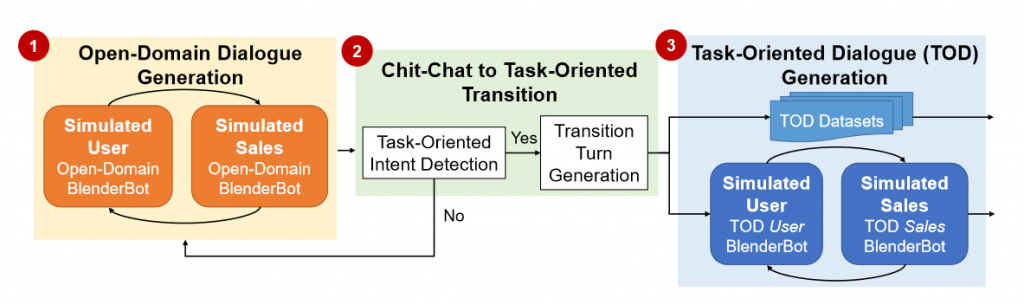

本文将闲聊到任务型对话的过程分为了三个主要阶段:

- 开放域对话闲聊

- 开放域聊天到面向非任务型聊天的过渡

- 任务型对话(TOD)生成

本文使用2021的SOTA BlenderBot来作为机器人对话生成模型。当然,这是一个框架,他并不强依赖于使用什么模型来进行文本生成。

闲聊

为了模拟对话时的两个角色,本文训练了两个BlenderBot来分别作为客户和销售者两个角色来进行对话。

过渡

对于由闲聊到任务型对话的转换,如何捕获合适的推销时机以及如何进行任务转换是两个十分重要的问题。因此本文采用了一个基于任务的意图检测模型来获取到底在什么时候进行推销;同时使用一个文本生成器来生成合适的闲聊-任务的转化文本。

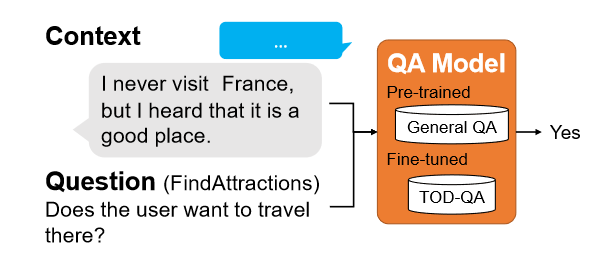

意图检测

相对于传统的意图检测模型,本任务的意图往往不那么明显(因为是基于闲聊的隐性意图),因此一方面使用QA来进行意图检测——即“上文涉及到xx意图么?”

还使用了一个基于Quora Question Pairs Data(一个相似问数据集)训练的T5来改写问题。

转换文本

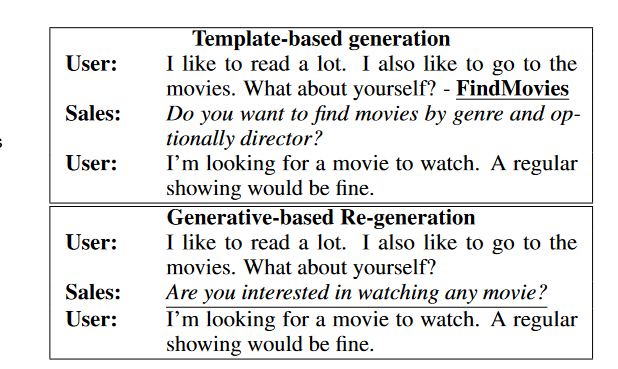

当检测到可以转换意图后,为了让任务型对话的介入不那么生硬,因此采用了一个转化文本模块来过渡闲聊和任务型对话。

过度轮次生成包括了两个部分,一个是基于模板句来触发对应的用户意图,一个是改写模板句来获得更加合理流畅的句子。

使用模板的理由是足够直接,能够很好地被学习。但是正是由于足够直接,对于用户来说表现得过于具有侵略性,因此需要生成改写。

而通过使用数据集OTTers( ACL 2021 单轮主题转换对话数据集 )来让生成模型学会在两个topic之间进行连贯转换(闲聊和任务型对话可以视为两个topic)

TOD对话生成

本文使用了两个BlenderBot来作为TOD的两个不同的角色,模拟对话。

实验

通过亚马逊人工评审,效果八错(不告诉人工这是生成的,就说是新手推销人员,从合理性、鲁莽性等方面进行评比)

结论

结论就是他们的这个数据集还是不错的

总结

一个数据集论文,成果以及贡献都是数据集,但是提出的框架还是挺不错的,提供了一个从闲聊顺滑的转移到任务型对话的框架。

0 条评论